안녕하세요, 여러분! 🎉 오늘은 AI 기술에 관심 있는 분들이라면 주목해야 할 한국의 혁신적인 기술에 대해 이야기해 보려고 해요. LG AI연구원이 2025년 3월 18일에 공개한 '엑사원 딥(EXAONE Deep)'이라는 추론 AI 모델인데요, 이 모델이 2025학년도 수능 수학에서 94.5점을 기록했다는 소식 들으셨나요?

미국의 오픈AI나 구글, 중국의 딥시크 등 글로벌 기업들만 가능하다고 여겨졌던 고성능 추론 AI를 한국 기업인 LG가 자체 개발했다는 사실이 정말 놀랍습니다. 특히 토종 AI가 글로벌 경쟁에서 우수한 성적을 거두고 있다는 점은 한국 AI 기술의 발전 가능성을 보여주는 중요한 이정표가 되었어요.

지금부터 엑사원 딥은 어떤 모델인지, 성능은 어떠한지, 그리고 실제로 7.8B 모델을 사용해본 경험까지 자세히 살펴보겠습니다. AI에 관심 있는 분들이라면 꼭 알아두셔야 할 내용이니 끝까지 함께해 주세요! 💡

엑사원 딥(EXAONE Deep)이란? 한국 AI 기술의 새로운 도약

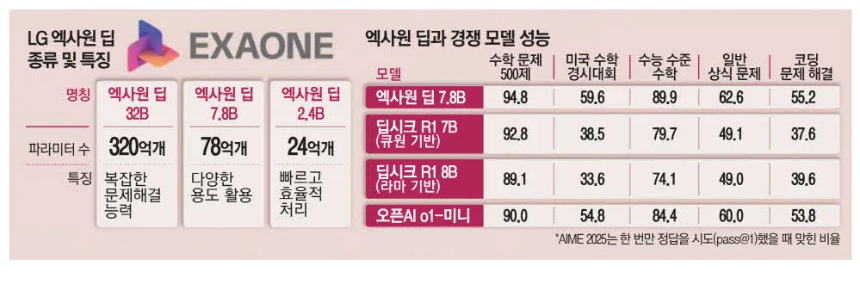

엑사원 딥은 크게 세 가지 모델로 구성되어 있습니다:

- 엑사원 딥-32B: 320억 개의 매개변수를 가진 주력 모델

- 엑사원 딥-7.8B: 78억 개의 매개변수를 가진 경량 모델

- 엑사원 딥-2.4B: 24억 개의 매개변수를 가진 온디바이스 모델

가장 주목할 만한 점은 엑사원 딥-32B 모델이 중국 딥시크 R1(6,710억 개 매개변수)의 불과 5% 크기로 개발되었음에도 수학, 과학, 코딩 분야에서 뛰어난 성능을 보인다는 것입니다.

매개변수는 AI 모델의 신경망에서 학습 가능한 파라미터로, 인간 뇌의 시냅스와 유사한 역할을 합니다. 일반적으로 매개변수가 많을수록 모델의 성능이 좋아지지만, 엑사원 딥은 효율적인 설계로 적은 매개변수로도 높은 성능을 달성했어요.

또한 엑사원 딥은 LG의 자체 파운데이션 모델인 '엑사원'을 기반으로 개발되어 한국어 처리 능력이 뛰어나다는 강점이 있습니다. 이는 수능과 같은 한국어 기반 시험에서 높은 성능을 발휘할 수 있는 이유이기도 하죠.

LG AI연구원은 엑사원 딥을 오픈소스로 공개함으로써 개방형 AI 연구 생태계 활성화에 기여하고, 엑사원 생태계를 확장하려는 전략적 결정을 내렸습니다. 이는 한국 AI 기술의 발전과 글로벌 경쟁력 강화를 위한 중요한 발걸음이라고 할 수 있어요.

엑사원 딥의 놀라운 성능, 글로벌 AI와 견주다

이는 중국의 딥시크 R1(89.9점)보다 높은 점수로, 모델 크기가 훨씬 작음에도 이루어낸 놀라운 성과입니다. 특히 고난도 수학 문제인 AIME(American Invitational Mathematics Examination) 2024, AIME 2025에서도 엑사원 딥은 각각 90.0점을 기록하며, 딥시크 R1과 동등한 성능을 보여주었어요. 이는 LG의 AI 모델이 단순히 한국어에 특화된 것이 아니라, 글로벌 표준의 고난도 수학 문제 해결 능력도 갖추고 있음을 증명합니다.

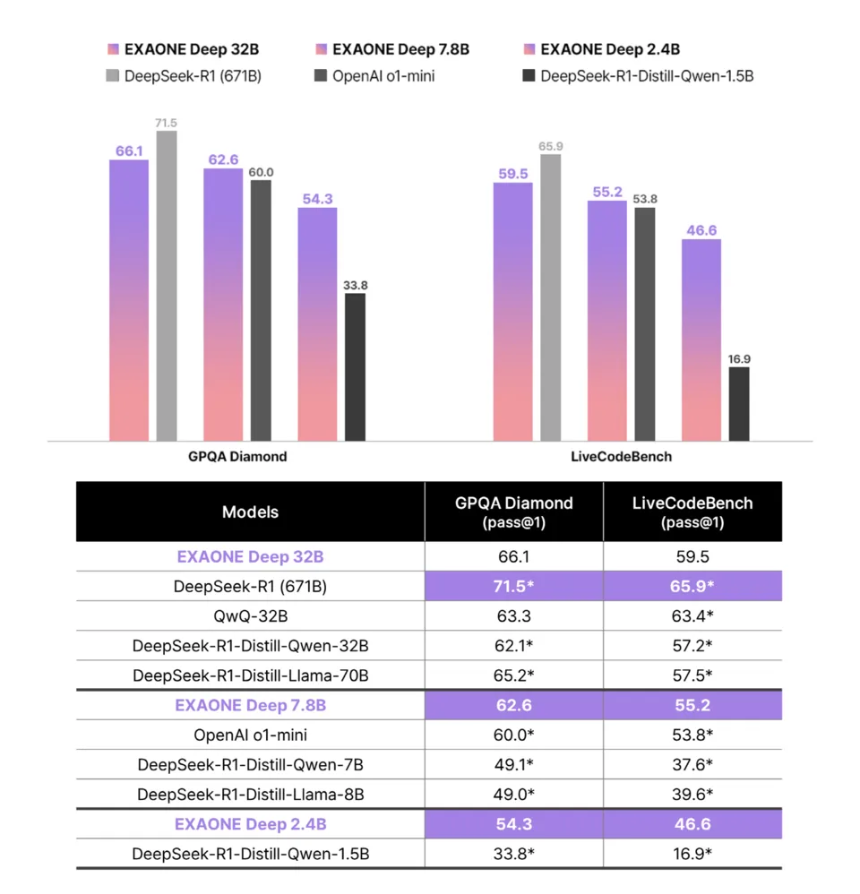

과학 분야에서도 엑사원 딥은 우수한 성능을 보였습니다. 물리학, 화학, 생물학 분야 박사 수준의 고난도 문제 해결 능력을 측정하는 GPQA 다이아몬드 평가에서 엑사원 딥은 66.1점을 기록했습니다. 딥시크 R1(71.5점)보다는 다소 낮지만, 모델 크기를 고려하면 매우 효율적인 성능이라고 할 수 있어요.

코딩 분야에서도 엑사원 딥은 LiveCodeBench 테스트에서 59.5점을 기록하며 경쟁력을 보여주었습니다. 비록 딥시크 R1(65.9점)보다는 낮지만, 프로그램 코드 작성 능력도 인증받았다고 볼 수 있죠.

특히 경량 모델인 엑사원 딥-7.8B와 온디바이스 모델인 엑사원 딥-2.4B도 놀라운 성능을 보였습니다:

- 7.8B 모델: MATH-500에서 94.8점, AIME 2025에서 59.6점 기록

- 2.4B 모델: MATH-500에서 92.3점, AIME 2024에서 47.9점 기록

7.8B 모델은 오픈AI의 'o1-미니'보다 높은 성능을 보이며, 작은 크기에도 불구하고 매우 높은 성능을 입증했습니다.

엑사원 딥 7.8B 모델 사용 후기와 실제 활용 방안

먼저, 엑사원 딥-7.8B는 말을 생성하는 능력이 뛰어났습니다. 특히 한국어 처리에 있어서는 매우 자연스러운 문장을 맥락에 맞게 생성해 내는 모습을 보였어요. 다만, 주목할 만한 특징 중 하나는 동일한 질문에 대해 거의 동일한 답변을 제공한다는 점이었습니다. 이는 ChatGPT와 같은 다른 LLM 모델과는 다소 다른 특성으로, 질문에 마침표를 몇 개 추가하는 등의 사소한 변화를 주면 비슷하지만 약간 다른 결과가 나오는 것으로 보아 LLM 캐시의 영향인 것으로 추측됩니다.

또한, 엑사원 딥-7.8B는 할루시네이션(환각, 즉 AI가 사실이 아닌 정보를 생성하는 현상)을 방지하기 위한 노력이 엿보였습니다. 특정 잘못된 질문을 던져도 사실과 거짓을 비교적 잘 분류해 답변하는 모습을 보였어요. 다만, 특정 사건의 발생 연도와 같은 사실 정보를 물어볼 때는 가끔 오류를 보이기도 했습니다.

엑사원 딥-7.8B 모델의 실제 활용 방안은 다양합니다. 서버나 클라우드 환경에서 주로 활용될 것으로 예상되며, 다음과 같은 분야에서 특히 유용할 것입니다:

- 교육 분야: AI 수학 튜터, 과학 문제 풀이 서비스 등

- 코딩 지원: 프로그래밍 자동화, AI 코드 검토 등

- 연구 지원: 과학적 추론이 필요한 연구 분야

- 기업용 AI 서비스: 다양한 기업 환경에서의 AI 솔루션

특히 상대적으로 가벼운 모델 크기 덕분에 적은 컴퓨팅 자원으로도 운영이 가능하므로, 비용 효율적인 AI 솔루션을 구축하는 데 큰 도움이 될 것입니다.

엑사원 딥이 한국 AI 기술에 미치는 영향과 미래 전망

특히 엑사원 딥이 적은 매개변수로도 효율적인 성능을 구현해낸 점은 AI 기술의 새로운 방향성을 제시합니다. 현재 AI 업계는 모델 크기를 키우는 방향으로 발전해 왔지만, 이는 엄청난 컴퓨팅 자원과 에너지를 필요로 합니다. 엑사원 딥은 효율성에 초점을 맞춘 접근법으로, 더 지속 가능한 AI 발전 모델을 제시한다고 볼 수 있어요.

또한 엑사원 딥의 개방형 접근 방식도 주목할 만합니다. LG AI연구원은 지난해 12월 엑사원 3.5 기반 모델들을 오픈소스로 공개한 데 이어, 이번에도 엑사원 딥을 오픈소스로 공개했습니다. 이는 개방형 AI 연구 생태계 활성화에 기여하고, 더 많은 개발자와 연구자들이 이를 활용해 다양한 혁신을 이룰 수 있는 기반을 마련하는 것입니다.

미래 전망으로는, 엑사원 딥의 세 가지 모델이 각각 다른 환경에서 폭넓게 활용될 것으로 예상됩니다:

- 엑사원 딥-32B: 기업의 고성능 AI 서비스, 연구소, 교육 기관 등에서 활용

- 엑사원 딥-7.8B: 클라우드 기반 AI 서비스, 비용 효율적인 기업 솔루션 등에 활용

- 엑사원 딥-2.4B: 스마트폰, 자동차, 로봇 등 다양한 디바이스에 내장되어 활용

특히 온디바이스 모델인 2.4B는 보안과 개인정보 보호 측면에서 강점이 있어, 휴대폰, 자동차, 로봇 등 다양한 산업에서 유용하게 활용될 것입니다. 또한 인터넷 연결 없이도 작동 가능하여 네트워크 환경이 불안정한 상황에서도 안정적인 AI 서비스를 제공할 수 있어요.

한국 AI의 새로운 지평을 열다

LG AI연구원의 엑사원 딥은 한국 AI 기술의 새로운 지평을 열었다고 해도 과언이 아닙니다. 수능 수학에서 94.5점을 기록하고, 고난도 수학 문제 해결에서 글로벌 경쟁력을 입증한 이 모델은 한국 기업이 세계적 수준의 AI 기술을 보유하고 있음을 보여주었어요.

특히 주목할 만한 점은 엑사원 딥이 단순히 성능만 좋은 것이 아니라, 효율성과 실용성도 겸비했다는 것입니다. 32B 모델부터 7.8B 경량 모델, 2.4B 온디바이스 모델까지 다양한 환경에 최적화된 모델을 제공함으로써, 여러 산업 분야에서 폭넓게 활용될 수 있는 가능성을 열었습니다.

이제 우리는 엑사원 딥을 어떻게 활용할 것인지 고민해볼 때입니다. 교육, 연구, 산업 등 다양한 분야에서 엑사원 딥의 뛰어난 추론 능력을 활용한다면, 우리의 일상과 업무는 더욱 효율적이고 창의적으로 변화할 것입니다.

여러분도 엑사원 딥에 관심이 생기셨나요? 지금 바로 LG AI연구원 공식 홈페이지나 깃허브 페이지를 방문하여 자세한 정보를 알아보고, 직접 모델을 체험해 보는 것은 어떨까요? 한국이 자랑하는 최첨단 AI 기술을 경험해보세요! 💡

엑사원 딥 체험하기'이슈' 카테고리의 다른 글

| 두바이 포르타 포티 의혹: 인플루언서 마리아 코발추크의 충격적인 실종과 발견 (0) | 2025.03.25 |

|---|---|

| 산불 호마의식 음모론, 실제 진실은? 대응 3단계 발령된 전국 산불 현황 총정리 (0) | 2025.03.25 |

| 미국의 '민감국가' 리스트에 한국이 포함된 충격적 사실! 동맹국 최초 지정의 의미와 영향은? (4) | 2025.03.16 |

| MG손해보험 매각 무산! 청산 위기에 처한 124만 계약자의 운명은? (0) | 2025.03.15 |

| 헌재 감사원장·검사 탄핵 기각, 윤석열 대통령 탄핵심판에 미치는 영향은? (2) | 2025.03.15 |